Die Forschung zu großen Sprachmodellen hat in den letzten Jahren ein enormes Wachstum erlebt. Eine immer größere Anzahl an Studien untersucht die Leistungsfähigkeit und Anwendungsbereiche dieser Modelle, was zu einer Flut an wissenschaftlichen Arbeiten führt. Die Herausforderung besteht darin, diese Ergebnisse systematisch zu bewerten, um fundierte Erkenntnisse über die tatsächliche Leistungsfähigkeit von KI-Modellen zu gewinnen. Klassische Meta-Analysen sind aufwendig und zeitintensiv, da sie Studien manuell sichten, relevante Daten extrahieren und zusammenführen. Eine automatisierte Methode könnte diesen Prozess revolutionieren, indem sie schneller, effizienter und kontinuierlich aktualisierbar ist.

Herausforderungen klassischer Meta-Analysen

Traditionelle Meta-Analysen erfordern eine sorgfältige Auswahl relevanter Studien, um verlässliche Schlussfolgerungen zu ziehen. Die erste Schwierigkeit liegt in der Identifikation hochwertiger Forschungsarbeiten, da viele Studien auf Preprint-Servern wie arXiv veröffentlicht werden, ohne dass sie ein Peer-Review-Verfahren durchlaufen haben. Eine weitere Herausforderung ist die Heterogenität der Methoden, Metriken und Benchmarks, die in verschiedenen Studien verwendet werden. Unterschiedliche Aufgabenstellungen, Trainingsdaten und Evaluationsmethoden erschweren direkte Vergleiche, sodass klassische Meta-Analysen große Anstrengungen erfordern, um vergleichbare Datensätze zu erstellen.

Die Rolle von Large Language Models in der wissenschaftlichen Analyse

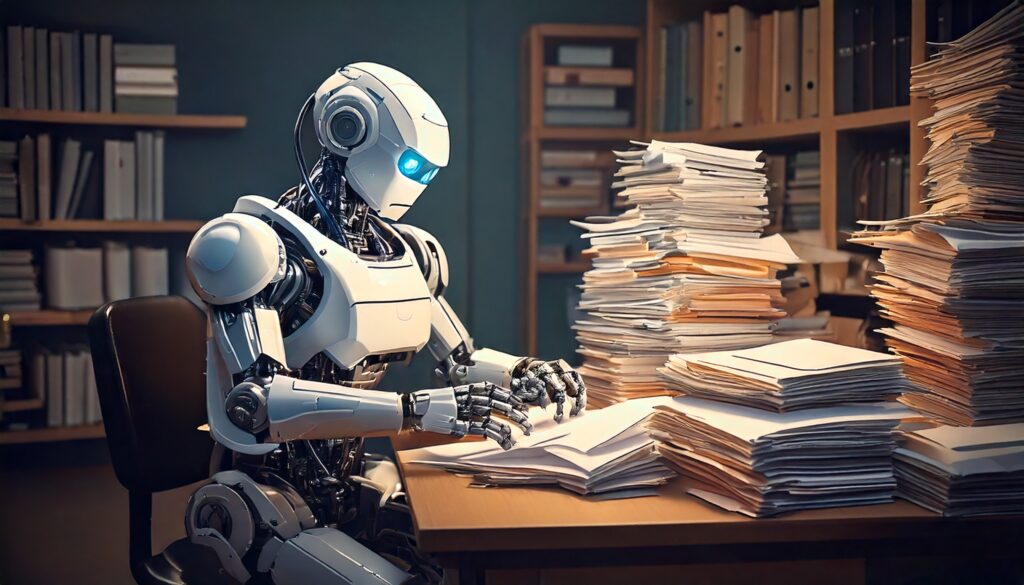

Mit dem Fortschritt von Large Language Models (LLMs) eröffnen sich neue Möglichkeiten zur Automatisierung von Forschungsprozessen. LLMs haben sich als leistungsfähig erwiesen, um große Mengen an Texten zu analysieren, relevante Informationen zu extrahieren und strukturiert darzustellen. Besonders in der systematischen Literaturrecherche bieten sie das Potenzial, die Effizienz von Meta-Analysen erheblich zu steigern. Indem sie automatisiert wissenschaftliche Arbeiten durchsuchen, relevante Passagen erkennen und Daten extrahieren, könnten sie den manuellen Aufwand drastisch reduzieren.

Notwendigkeit automatisierter Meta-Analysen

Die Geschwindigkeit, mit der neue Forschungsergebnisse zu KI-Modellen veröffentlicht werden, übersteigt die Kapazitäten herkömmlicher Analyseverfahren. Ein manuelles Review sämtlicher neuer Veröffentlichungen ist kaum noch realistisch. Besonders im Bereich der Evaluierung von Sprachmodellen ist eine kontinuierliche Aktualisierung der verfügbaren Daten entscheidend, da neue Benchmarks und Testmethoden regelmäßig eingeführt werden. Eine automatisierte Meta-Analyse kann nicht nur existierende Arbeiten systematisch zusammenfassen, sondern auch neue Trends identifizieren und Forschungsergebnisse dynamisch aktualisieren.

Vorteile einer datengetriebenen Analyse

Eine automatisierte Meta-Analyse nutzt die Rechenleistung moderner KI-Modelle, um objektive und reproduzierbare Zusammenfassungen wissenschaftlicher Erkenntnisse zu erstellen. Während manuelle Methoden von subjektiven Bewertungen abhängen, kann eine algorithmische Analyse inkonsistente oder fehlerhafte Datenquellen aufdecken und so die Verlässlichkeit der Ergebnisse erhöhen. Eine automatisierte Extraktion und Aggregation von Forschungsergebnissen reduziert Verzerrungen durch selektive Berichtserstattung und ermöglicht eine umfassendere Bewertung von Entwicklungen im Bereich der großen Sprachmodelle.

Die Notwendigkeit automatisierter Datenextraktion

Die steigende Anzahl wissenschaftlicher Arbeiten über große Sprachmodelle erschwert die manuelle Analyse und Bewertung aktueller Forschungsergebnisse. Die herkömmliche Methode, Studien zu sichten, relevante Daten zu extrahieren und in Meta-Analysen zusammenzuführen, ist nicht nur zeitintensiv, sondern auch fehleranfällig. Eine automatisierte Datenextraktion kann diesen Prozess erheblich beschleunigen und dabei gleichzeitig die Qualität der Analyse verbessern.

Herausforderungen manueller Datenanalyse

Meta-Analysen basieren auf der systematischen Zusammenstellung und Auswertung von Ergebnissen aus verschiedenen Studien. Bei herkömmlichen Methoden müssen Forschende die wissenschaftlichen Arbeiten manuell durchsuchen, relevante Informationen identifizieren und in eine strukturierte Form bringen. Dies führt zu einer Reihe von Problemen, darunter inkonsistente Berichterstattung, Unterschiede in der Methodik und die Abhängigkeit von subjektiven Bewertungen.

Die Heterogenität der verwendeten Metriken erschwert direkte Vergleiche. Sprachmodelle werden mit unterschiedlichen Benchmarks getestet, und nicht alle Studien geben vollständige Informationen über die Trainingsdaten, Hyperparameter oder Evaluationskriterien an. Diese Faktoren führen dazu, dass selbst erfahrene Forschende Schwierigkeiten haben, eine zuverlässige Zusammenfassung aus der Fülle an Veröffentlichungen zu erstellen.

Potenzial automatisierter Methoden

Die Anwendung großer Sprachmodelle zur automatisierten Datenextraktion bietet eine effiziente Alternative zur manuellen Analyse. Durch den Einsatz moderner Natural Language Processing-Technologien können große Mengen wissenschaftlicher Texte in kurzer Zeit analysiert werden. Diese Modelle sind in der Lage, relevante Informationen zu identifizieren, Tabellen und Diagramme zu interpretieren und Ergebnisse in standardisierte Formate zu überführen.

Ein entscheidender Vorteil dieser automatisierten Methode ist die Fähigkeit, Studien systematisch nach bestimmten Kriterien zu filtern. Während manuelle Meta-Analysen häufig eine begrenzte Anzahl an Arbeiten berücksichtigen, können KI-gestützte Ansätze einen viel größeren Pool an Studien verarbeiten und dadurch ein umfassenderes Bild der aktuellen Forschungslage liefern.

Konsistenz und Objektivität der Datenextraktion

Automatisierte Meta-Analysen reduzieren das Risiko subjektiver Verzerrungen. Während menschliche Forschende durch persönliche Präferenzen oder kognitive Verzerrungen beeinflusst werden können, analysieren KI-Systeme die Daten objektiv anhand vordefinierter Kriterien. Dies verbessert die Reproduzierbarkeit wissenschaftlicher Analysen und minimiert Fehler, die durch selektive Berichtserstattung oder uneinheitliche Dokumentationspraktiken entstehen können.

Ein weiterer Vorteil liegt in der Skalierbarkeit. Während herkömmliche Meta-Analysen oft Monate oder Jahre in Anspruch nehmen, kann eine automatisierte Extraktion und Aggregation von Daten in einem Bruchteil der Zeit erfolgen. Dies ermöglicht eine kontinuierliche Aktualisierung der Analyse, sodass neue Forschungsergebnisse sofort in den bestehenden Wissensstand integriert werden können.

Effizienzsteigerung durch Machine Learning

Moderne Machine-Learning-Modelle sind darauf trainiert, Zusammenhänge zwischen Studien zu erkennen und relevante Informationen automatisch zu extrahieren. Dabei können sie nicht nur einzelne Arbeiten analysieren, sondern auch Trends über mehrere Veröffentlichungen hinweg identifizieren. Dies erlaubt eine tiefere Einsicht in die Entwicklung bestimmter Forschungsfragen und verbessert die Qualität der Meta-Analyse.

Durch den Einsatz automatisierter Methoden lassen sich umfassendere und präzisere Bewertungen von Sprachmodellen erstellen. Indem große Mengen an Studien effizient verarbeitet werden, können KI-gestützte Analysen bessere Einblicke in die tatsächliche Leistungsfähigkeit von Modellen liefern und die wissenschaftliche Forschung erheblich beschleunigen.

Die semi-automatisierte Meta-Analyse-Methode

Die steigende Anzahl wissenschaftlicher Publikationen erfordert neue Ansätze zur systematischen Zusammenfassung von Forschungsergebnissen. Eine semi-automatisierte Meta-Analyse kombiniert maschinelle Effizienz mit menschlicher Expertise, um relevante Informationen aus einer Vielzahl wissenschaftlicher Arbeiten zu extrahieren und strukturiert aufzubereiten. Dieser Ansatz nutzt Large Language Models (LLMs), um Studien gezielt zu identifizieren, relevante Daten herauszufiltern und so eine umfassendere Bewertung aktueller Forschungsergebnisse zu ermöglichen.

Identifikation relevanter Publikationen mit LLMs

Eine der größten Herausforderungen bei Meta-Analysen ist die Auswahl relevanter Studien. Während herkömmliche Methoden eine manuelle Durchsicht wissenschaftlicher Datenbanken erfordern, nutzen KI-gestützte Systeme Machine-Learning-Algorithmen, um relevante Veröffentlichungen automatisch zu identifizieren. Dabei werden Schlüsselwörter, Zitationsmuster und thematische Ähnlichkeiten analysiert, um eine systematische Sammlung hochwertiger Studien zu erstellen.

Der Vorteil dieses Ansatzes liegt in der Geschwindigkeit und Präzision der Auswahl. Während menschliche Forschende Wochen oder Monate benötigen, um relevante Arbeiten zu sichten, können LLMs diesen Prozess innerhalb weniger Minuten durchführen. Die Algorithmen erkennen Muster und Zusammenhänge in Forschungsarbeiten, die auf den ersten Blick nicht offensichtlich sind, wodurch auch weniger bekannte, aber relevante Studien einbezogen werden.

Extraktion experimenteller Ergebnisse

Nach der Identifikation relevanter Studien ist die systematische Extraktion experimenteller Ergebnisse der nächste Schritt. Hierbei analysieren LLMs wissenschaftliche Texte, um spezifische Informationen zu extrahieren. Dazu gehören Leistungsmetriken von Sprachmodellen, Benchmark-Ergebnisse und experimentelle Rahmenbedingungen. KI-Modelle sind in der Lage, numerische Daten aus Tabellen zu erfassen und automatisch in standardisierte Formate zu überführen.

Ein zentraler Vorteil der automatisierten Extraktion ist die Reduzierung menschlicher Fehler. Manuelle Analysen sind anfällig für Übertragungsfehler, subjektive Interpretationen oder unvollständige Datensätze. KI-Modelle nutzen präzise Algorithmen, um relevante Daten punktgenau zu extrahieren und deren Struktur beizubehalten. Dies sorgt für eine konsistente und zuverlässige Datenbasis, die für eine fundierte Meta-Analyse unerlässlich ist.

Strukturierung und Vergleichbarkeit der Daten

Ein großes Problem traditioneller Meta-Analysen ist die Heterogenität wissenschaftlicher Methoden. Unterschiedliche Studien verwenden verschiedene Metriken, Datensätze und Evaluationsverfahren, was direkte Vergleiche erschwert. Die semi-automatisierte Meta-Analyse löst dieses Problem, indem sie extrahierte Daten automatisch harmonisiert.

Durch statistische Normalisierungstechniken werden Ergebnisse auf eine vergleichbare Basis gebracht. KI-Modelle erkennen inkonsistente Maßeinheiten oder abweichende Definitionen von Metriken und wandeln diese in einheitliche Formate um. Dadurch wird sichergestellt, dass alle Studien unter den gleichen Bedingungen interpretiert werden, was die Qualität der Analyse erheblich verbessert.

Reduktion von Publikationsverzerrungen

Ein weiteres Problem wissenschaftlicher Forschung ist die selektive Berichterstattung. Studien mit signifikanten Ergebnissen werden häufiger veröffentlicht als solche mit negativen oder nicht signifikanten Befunden. Dies führt zu einer systematischen Verzerrung, die traditionelle Meta-Analysen beeinflussen kann.

Durch die automatisierte Identifikation und Extraktion großer Mengen an Publikationen wird das Risiko von Verzerrungen minimiert. LLMs berücksichtigen nicht nur hochzitierte Arbeiten, sondern auch weniger bekannte Studien, die möglicherweise wertvolle, aber unterrepräsentierte Erkenntnisse enthalten. Dadurch entsteht ein vollständigeres Bild der tatsächlichen Forschungslandschaft.

Effizienz und Skalierbarkeit der Methode

Der größte Vorteil der semi-automatisierten Meta-Analyse liegt in ihrer Skalierbarkeit. Während herkömmliche Methoden stark von der Arbeitskapazität der Forschenden abhängig sind, kann eine KI-gestützte Analyse kontinuierlich neue Daten integrieren. Dies ermöglicht eine Echtzeit-Aktualisierung wissenschaftlicher Erkenntnisse, sodass neue Veröffentlichungen sofort in bestehende Meta-Analysen einfließen.

Indem große Datenmengen effizient verarbeitet und harmonisiert werden, schafft die semi-automatisierte Methode eine Grundlage für präzisere und umfassendere wissenschaftliche Bewertungen. Dies trägt dazu bei, Forschungsfragen schneller zu beantworten und neue Entwicklungen im Bereich der großen Sprachmodelle objektiver zu bewerten.

Validierung und neue Erkenntnisse durch die Methode

Die semi-automatisierte Meta-Analyse ermöglicht nicht nur eine effizientere Verarbeitung wissenschaftlicher Studien, sondern auch eine detailliertere Überprüfung bereits bestehender Erkenntnisse. Durch den Einsatz von Large Language Models zur systematischen Datenextraktion und -analyse konnten zentrale Annahmen über große Sprachmodelle überprüft und neue wissenschaftliche Einsichten gewonnen werden.

Reproduktion früherer Meta-Analysen

Ein entscheidender Test für die Zuverlässigkeit der Methode ist die Reproduktion bestehender Meta-Analysen. Eine der wichtigsten Fragestellungen im Bereich großer Sprachmodelle betrifft die Effektivität der „Chain-of-Thought“-Technik (CoT), bei der Sprachmodelle durch schrittweise Überlegungen zu besseren Ergebnissen geführt werden. Frühere manuelle Meta-Analysen hatten gezeigt, dass CoT-Methoden in vielen Fällen zu signifikanten Verbesserungen führen.

Die semi-automatisierte Meta-Analyse bestätigte diese Ergebnisse, indem sie eine Vielzahl neuer Studien in die Analyse integrierte und die Leistungsmessungen der Modelle auf standardisierte Weise aggregierte. Die Analyse zeigte, dass der Nutzen von CoT-Techniken besonders bei komplexen logischen Aufgaben signifikant ist, während der Effekt bei einfacheren Fragestellungen weniger ausgeprägt erscheint.

Neue Erkenntnisse zur In-Context-Learning-Strategie

Neben der Validierung bestehender Ergebnisse ermöglichte die Methode auch neue Einsichten. Eine zentrale Frage in der aktuellen Forschung ist, wie viele Beispielaufforderungen (Prompts) ein Sprachmodell benötigt, um eine Aufgabe optimal zu lösen. Die semi-automatisierte Analyse identifizierte eine Korrelation zwischen der Anzahl der gegebenen Beispiele und der Modellleistung bei multimodalen Aufgaben.

Die extrahierten Daten zeigten, dass für einige Aufgaben nur wenige In-Context-Beispiele ausreichen, um signifikante Verbesserungen zu erzielen, während bei anderen Aufgaben der Nutzen mit zunehmender Anzahl an Beispielen abnimmt. Diese Erkenntnis bietet eine wichtige Grundlage für die Optimierung von Prompt-Strategien in realen Anwendungen.

Einfluss von Skalierung und Architektur auf die Leistung

Ein weiteres wichtiges Forschungsthema betrifft die Frage, inwieweit die Größe eines Sprachmodells dessen Leistung beeinflusst. Frühere Studien hatten gezeigt, dass größere Modelle in der Regel bessere Ergebnisse erzielen, allerdings mit abnehmenden Erträgen („diminishing returns“). Die semi-automatisierte Meta-Analyse untersuchte diesen Zusammenhang auf Basis einer Vielzahl aktueller Veröffentlichungen.

Die Ergebnisse bestätigten, dass Skalierung weiterhin ein wichtiger Faktor für die Modellleistung ist, allerdings nicht in allen Bereichen gleich stark. Während größere Modelle in Aufgaben mit komplexen logischen Strukturen oder Wissensabruf deutlich besser abschnitten, waren die Verbesserungen in anderen Bereichen, wie der syntaktischen Analyse, marginal. Dies deutet darauf hin, dass zukünftige Forschungsanstrengungen verstärkt auf architektonische Innovationen statt auf reine Modellskalierung fokussiert werden könnten.

Bedeutung für die Weiterentwicklung von Sprachmodellen

Die Fähigkeit, bestehende wissenschaftliche Erkenntnisse zu validieren und neue Einsichten zu gewinnen, macht die semi-automatisierte Meta-Analyse zu einem wertvollen Werkzeug für die Weiterentwicklung großer Sprachmodelle. Durch die kontinuierliche Integration neuer Forschungsdaten kann diese Methode dazu beitragen, aktuelle Trends frühzeitig zu erkennen und Optimierungsstrategien für künftige KI-Modelle zu entwickeln.

Indem große Mengen wissenschaftlicher Studien effizient analysiert und vergleichbare Datenstrukturen geschaffen werden, verbessert sich nicht nur die Qualität der Forschung, sondern auch die Entscheidungsgrundlage für Wissenschaftler und Unternehmen, die Sprachmodelle in ihren Anwendungen nutzen. Die neue Methode bietet somit ein leistungsfähiges Instrument, um fundierte wissenschaftliche Erkenntnisse systematisch zu erfassen und weiterzuentwickeln.

Kontinuierliche Aktualisierung und zukünftige Anwendungen

Die semi-automatisierte Meta-Analyse bietet die Möglichkeit, wissenschaftliche Erkenntnisse nicht nur effizienter zu synthetisieren, sondern auch kontinuierlich zu aktualisieren. Die schnelle Entwicklung von Large Language Models erfordert eine flexible Methode, die sich dynamisch an neue Veröffentlichungen anpassen kann. Indem automatisierte Systeme regelmäßig neue Forschungsarbeiten analysieren, entsteht eine stets aktuelle und umfassende Übersicht über den aktuellen Stand der Wissenschaft.

Dynamische Integration neuer Studien

Der größte Vorteil der automatisierten Analyse liegt in ihrer Skalierbarkeit. Während klassische Meta-Analysen statische Zusammenfassungen bieten, kann die semi-automatisierte Methode kontinuierlich neue Veröffentlichungen integrieren. Dies geschieht durch eine permanente Durchsuchung wissenschaftlicher Datenbanken, die relevanten Studien anhand festgelegter Kriterien identifiziert.

Die Aktualisierung der Analyse erfolgt durch die automatische Extraktion neuer experimenteller Ergebnisse und deren Integration in die bestehende Datengrundlage. Dies bedeutet, dass wissenschaftliche Erkenntnisse nicht nur retrospektiv betrachtet, sondern in Echtzeit angepasst werden können. Insbesondere in Forschungsfeldern mit hoher Innovationsgeschwindigkeit ist diese Fähigkeit entscheidend, um stets auf dem neuesten Stand zu bleiben.

Potenzial für andere Forschungsbereiche

Obwohl die Methode zur Analyse großer Sprachmodelle entwickelt wurde, lassen sich die Prinzipien auch auf andere wissenschaftliche Disziplinen übertragen. In der Medizin kann eine kontinuierlich aktualisierte Meta-Analyse dazu beitragen, die Wirksamkeit neuer Behandlungsmethoden schneller zu bewerten. In den Umweltwissenschaften kann sie helfen, langfristige Trends im Klimawandel präziser zu erfassen.

Ein weiteres Anwendungsfeld liegt in der Materialwissenschaft, wo automatisierte Meta-Analysen genutzt werden können, um neue Materialien mit optimalen physikalischen Eigenschaften zu identifizieren. Auch in den Sozialwissenschaften könnten KI-gestützte Methoden dazu beitragen, gesellschaftliche Trends und Verhaltensmuster über längere Zeiträume hinweg systematisch zu analysieren.

Herausforderungen und zukünftige Optimierungen

Trotz der zahlreichen Vorteile steht die semi-automatisierte Meta-Analyse vor Herausforderungen. Eine der größten Hürden liegt in der Qualität der zugrunde liegenden Daten. Wissenschaftliche Arbeiten weisen oft Unterschiede in ihrer Struktur, Methodik und Berichterstattung auf, was die automatische Extraktion von Ergebnissen erschweren kann. Künftige Entwicklungen könnten hier ansetzen, indem bessere Modelle zur Erkennung und Standardisierung wissenschaftlicher Informationen entwickelt werden.

Ein weiteres Problem ist die Bewertung der Vertrauenswürdigkeit einzelner Studien. Während klassische Meta-Analysen durch menschliche Expertise gesteuert werden, muss eine automatisierte Methode Mechanismen integrieren, um fehlerhafte oder methodisch schwache Arbeiten zu identifizieren. Zukünftige Systeme könnten Qualitätsbewertungen anhand von Peer-Review-Status, Zitierhäufigkeit oder methodischer Strenge vornehmen, um die Analyse noch robuster zu gestalten.

Bedeutung für die Wissenschaft und KI-Entwicklung

Die semi-automatisierte Meta-Analyse stellt einen wichtigen Schritt in der wissenschaftlichen Methodik dar. Sie ermöglicht nicht nur eine schnellere und präzisere Synthese bestehender Forschung, sondern legt auch den Grundstein für eine datengetriebene Entscheidungsfindung. In der KI-Forschung kann sie dazu beitragen, neue Optimierungsstrategien zu identifizieren und die Weiterentwicklung von Sprachmodellen effizienter zu gestalten.

Langfristig könnte diese Methode zu einem neuen Standard für die wissenschaftliche Analyse großer Datenmengen werden. Durch den Einsatz von Machine Learning und Natural Language Processing lassen sich Erkenntnisse schneller generieren, verzerrte Berichterstattung reduzieren und Forschungsergebnisse transparenter aufbereiten. Die Fähigkeit, wissenschaftliche Entwicklungen in Echtzeit zu verfolgen, wird zunehmend an Bedeutung gewinnen und den Weg für eine neue Generation datengetriebener Wissenschaft eröffnen. Die Studie finden Sie hier.